Apple hat eine neue Studie veröffentlicht, die zeigt, wie humanoide Roboter künftig effizienter trainiert werden können. Das Besondere daran: Die Maschinen lernen nicht mehr nur von anderen Robotern, sondern direkt von Menschen – und zwar aus deren Sicht. Möglich wird das durch eine Apple Vision Pro, die für die Datenerfassung genutzt wird. Die Studie heißt „Humanoid Policy ∼ Human Policy“ und wurde in Zusammenarbeit mit dem MIT, Carnegie Mellon, der University of Washington und der UC San Diego durchgeführt.

Robotertraining ist bisher aufwendig, teuer und schwer zu skalieren. Meist müssen Menschen über komplexe Teleoperationssysteme Roboter fernsteuern, um ihnen bestimmte Aufgaben beizubringen. Das kostet Zeit und Ressourcen. Apple schlägt nun einen anderen Weg ein: Roboter sollen menschliche Handlungen direkt aus Videos lernen, die aus der Ich-Perspektive gefilmt wurden. Dazu trägt die testende Person ein Headset – zum Beispiel die Apple Vision Pro – und führt einfache oder komplexe Handlungen mit Objekten aus. Die Aufnahmen werden dann genutzt, um eine KI zu trainieren, die humanoide Roboter anleiten kann.

Ego-Aufnahmen statt teurer Roboterdaten

In der Studie wurde untersucht, wie menschliche Demonstrationen aus der Ego-Perspektive (also direkt aus Sicht der handelnden Person) als Trainingsdaten genutzt werden können. Dafür wurden insgesamt über 25.000 menschliche und 1.500 robotergesteuerte Demonstrationen gesammelt. Diese Daten wurden in einem gemeinsamen Format zusammengeführt, das die Forscher „PH2D“ nennen. Ziel war es, eine einzige KI-Richtlinie zu entwickeln, die auf Basis beider Datenquellen (Mensch und Roboter) funktioniert. Die Forscher betonen, dass das reine Lernen aus Roboterdaten ineffizient ist. Die Erfassung ist teuer, erfordert komplexe Ausrüstung und lässt sich kaum in großem Maßstab umsetzen. Mit egozentrischen menschlichen Demonstrationen entsteht dagegen eine skalierbare Alternative, die flexibler eingesetzt werden kann.

So wurde die Apple Vision Pro eingesetzt

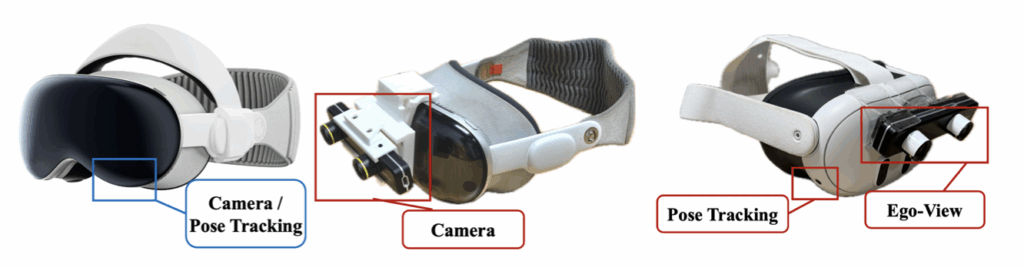

Um diese Art von Trainingsdaten zu erfassen, entwickelten die Forscher eine spezielle App für die Apple Vision Pro. Sie nutzt die untere linke Kamera des Headsets und das ARKit-Framework von Apple, um Kopf- und Handbewegungen dreidimensional zu erfassen. Damit lassen sich Handlungen aus der ersten Person aufzeichnen – inklusive aller Bewegungsdaten, die ein Roboter braucht, um die Aktion zu imitieren.

Um die Methode für mehr Menschen zugänglich zu machen, wurde zusätzlich eine Halterung entwickelt, mit der man eine ZED Mini Stereo-Kamera an anderen Headsets wie dem Meta Quest 3 befestigen kann. Damit lassen sich ähnliche 3D-Bewegungsdaten erfassen – nur deutlich günstiger.

Schnelleres und günstigeres Training

Ein weiterer Vorteil: Die Trainingsdaten können sehr schnell gesammelt werden. Während klassische Teleoperationen oft lange dauern, kann mit der neuen Methode in wenigen Sekunden eine komplette Demonstration aufgenommen werden. Das senkt nicht nur die Kosten, sondern macht das Training auch viel einfacher skalierbar. Ein Detail am Rande: Da Menschen sich bei Handlungen viel schneller bewegen als Roboter, mussten die aufgezeichneten Videos im Trainingsprozess künstlich verlangsamt werden – um den Faktor vier. So können die Roboter den menschlichen Handlungen folgen, ohne dass weitere Anpassungen nötig sind.

HAT – der Human Action Transformer

Das Herzstück des Projekts ist ein Modell namens HAT – Human Action Transformer. Es wurde darauf trainiert, sowohl menschliche als auch robotergenerierte Demonstrationen zu verarbeiten – und zwar nicht getrennt, sondern gemeinsam in einem einheitlichen Format. Der Vorteil: HAT lernt universelle Regeln für Manipulationsaufgaben, die unabhängig davon funktionieren, ob ein Mensch oder ein Roboter die Aufgabe zeigt. Tests zeigen, dass dieser gemeinsame Trainingsansatz dem Roboter geholfen hat, auch neue, unbekannte Aufgaben zu meistern. Im Vergleich zu klassischen Methoden, bei denen der Roboter nur aus Roboter-Beispielen lernt, ist HAT flexibler und benötigt weniger Daten.

Apple verbindet Mensch und Maschine in einem Lernmodell

Apple zeigt mit dieser Studie, wie das Training von humanoiden Robotern effizienter, günstiger und schneller werden kann. Statt auf aufwendige Teleoperationen zu setzen, nutzt das System einfache Ego-Videos, aufgenommen mit der Apple Vision Pro oder günstigen Alternativen. Die Kombination aus menschlichen und robotergenerierten Daten in einem gemeinsamen Modell ist dabei der zentrale Fortschritt. Wer sich für Robotik oder künstliche Intelligenz interessiert, bekommt mit dieser Arbeit einen spannenden Einblick in die Zukunft des maschinellen Lernens – mit Apple als einem der Treiber dieser Entwicklung. (Bild: Shutterstock / Golden Dayz)

- Apple baut geheimes Robotik-Team komplett um

- Foxconn: KI und Robotik übernehmen die Fließbänder

- OpenAI übernimmt Jony Ives Startup für neue KI-Geräte

- Google I/O: Das sind die spannendsten Ankündigungen 2025

- Wie gestohlene iPhones weltweit nach China geschleust werden